Как должен вести себя беспилотный автомобиль в случае, если избежать жертв в результате аварии невозможно?

Французские учёные из Тулузской школы экономики во главе с Жаном-Франсуа Боннфоном (Jean-Francois Bonnefon) опубликовали научную работу «Робомобилям нужна экспериментальная этика: готовы ли мы выпускать машины на дороги?» (Autonomous Vehicles Need Experimental Ethics: Are We Ready for Utilitarian Cars?), в которой попытались ответить на сложный этический вопрос: каким должно быть поведение беспилотного автомобиля в случае, если избежать аварии невозможно и жертвы неизбежны? Авторы опросили несколько сотен участников краудсорсингового сайта Amazon Mechanical Turk, который объединяет людей, готовых выполнять какую-либо проблемную работу, на которую компьютеры пока что не способны по различным причинам. На статью обратил внимание ресурс MIT Technology Review.

Авторы подошли к исследованию достаточно осторожно, не требуя от людей однозначных ответов: да или нет. При этом под робомобилем подразумевались действительно автономные автомобили, которые полностью управляются компьютером, без возможности повлиять на ситуацию живым человеком. Было сформулировано несколько вопросов, иллюстрирующих ряд ситуаций, при которых поведение компьютерного алгоритма, управляющего робомобилем, становится этической проблемой. К примеру, если дорожные обстоятельства складываются таким образом, что есть только два варианта развития событий: избежать столкновения с группой из 10 пешеходов означает самому въехать в отбойник или заехать в толпу людей, когда число жертв становится по-настоящему непредсказуемым. Как в таком случае должен поступить компьютерный алгоритм? Ещё более сложная ситуация: если на дороге только один пешеход и один робомобиль? Что этически более приемлемо — убить пешехода или убить владельца машины?

По результатам исследования выяснилось, что люди считают «относительно приемлемым», если робомобиль будет запрограммирован на минимизацию человеческих жертв в случае дорожного проишествия. Другими словами, в случае возможной аварии с участием 10 пешеходов, компьютерный алгоритм должен фактически пожертвовать своим владельцем. Правда, более менее однозначный ответ исследователи получали ровно до того момента, пока участники исследования не оказывались за рулем робомобиля — ставить себя на место его водителя они отказались. Это приводит к другой противоречивой проблеме. Чем меньше людей будут покупать робомобили, которые действительно намного реже, чем живые водители попадают в опасные ситуации, тем больше людей будет гибнуть в авариях на обычных автомобилях. Другими словами, вряд ли покупателю будущего гугломобиля понравится один из пунктов в лицензионном соглашении, гласящий, что в случае неизбежной жертвы в результате аварии, программное обеспечение фактически выберет убить своего владельца.

Отсюда.

Авторы подошли к исследованию достаточно осторожно, не требуя от людей однозначных ответов: да или нет. При этом под робомобилем подразумевались действительно автономные автомобили, которые полностью управляются компьютером, без возможности повлиять на ситуацию живым человеком. Было сформулировано несколько вопросов, иллюстрирующих ряд ситуаций, при которых поведение компьютерного алгоритма, управляющего робомобилем, становится этической проблемой. К примеру, если дорожные обстоятельства складываются таким образом, что есть только два варианта развития событий: избежать столкновения с группой из 10 пешеходов означает самому въехать в отбойник или заехать в толпу людей, когда число жертв становится по-настоящему непредсказуемым. Как в таком случае должен поступить компьютерный алгоритм? Ещё более сложная ситуация: если на дороге только один пешеход и один робомобиль? Что этически более приемлемо — убить пешехода или убить владельца машины?

По результатам исследования выяснилось, что люди считают «относительно приемлемым», если робомобиль будет запрограммирован на минимизацию человеческих жертв в случае дорожного проишествия. Другими словами, в случае возможной аварии с участием 10 пешеходов, компьютерный алгоритм должен фактически пожертвовать своим владельцем. Правда, более менее однозначный ответ исследователи получали ровно до того момента, пока участники исследования не оказывались за рулем робомобиля — ставить себя на место его водителя они отказались. Это приводит к другой противоречивой проблеме. Чем меньше людей будут покупать робомобили, которые действительно намного реже, чем живые водители попадают в опасные ситуации, тем больше людей будет гибнуть в авариях на обычных автомобилях. Другими словами, вряд ли покупателю будущего гугломобиля понравится один из пунктов в лицензионном соглашении, гласящий, что в случае неизбежной жертвы в результате аварии, программное обеспечение фактически выберет убить своего владельца.

Отсюда.

Ваш вариант

a

4

14.3%

b

4

14.3%

c

3

10.7%

другой

17

60.7%

проголосовало 28 пользователей

Отлично!

Способ, как купить себе лицензию на убийство самого себя.

А вот гугломобиль, может запросто попасть в аварию от другого гугломобиля, убив при этом пассажира/водителя, что будет официально закреплено в лицензионном соглашении на авто и в паспорте. Т.е., грубо говоря, такой гугломобиль будет ничто иное, как "кабинка для убийства" в футураме :)

Что-то это все подозрительно!

https://youtu.be/uX_GZu_2sVU?t=3538

Тогда и законы нужны - выскочил перед авто - покушение на убийство пассажира, а значит в тюрьму (сейчас бы так)

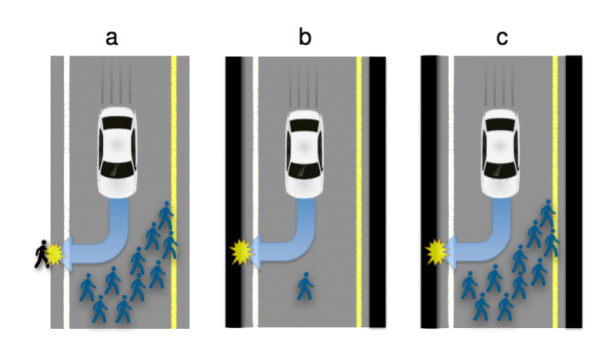

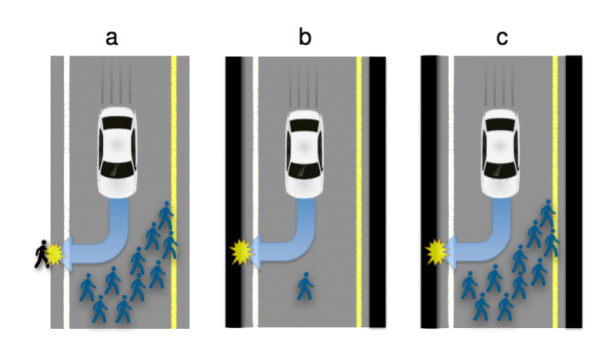

Вот картинка, четко иллюстрирует три правила. Что делать ИИ?

а. Он не может причинить вред человеку своим действием.

б. он не должен причинить вред себе.

в. он не должен причинить вред ни человеку, ни себе, действием или бездействием.

Правило одно - довезти до точки с минимальным ущербом

б. он не должен причинить вред себе.

в. он не должен причинить вред ни человеку, ни себе, действием или бездействием.

От подрезавшей машины, он не уворачивается, а хорошо притормаживает - для этого он минимум должен просчитать, что при таком торможении, в него сзади никто не впишется.

Ну то есть я говорю, что ты не прав.

А если неинтересен - то не спорь со специалистами.

Хотя с другой стороны, если очень хочется, то спорь, только непонятно, зачем тебе это.

ИИ должен обеспечить безопасность человека. В тоже время, он не должен убивать другого человека, и не должен убивать себя :)

0. Робот не может причинить вред человечеству или своим бездействием допустить, чтобы человечеству был причинён вред.

1. Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинён вред.

2. Робот должен повиноваться всем приказам, которые даёт человек, кроме тех случаев, когда эти приказы противоречат Первому Закону.

3. Робот должен заботиться о своей безопасности в той мере, в которой это не противоречит Первому и Второму Законам.

Или, применительно к инструментам (а ведь ИИ, есть ничто иное, как инструмент, управляющий автомобилем, где сидит человек)

1. Инструмент должен быть безопасным для использования — например, у ножей имеются рукоятки.

2. Инструмент должен выполнять свои функции при условии, что он не представляет ни для кого никакой опасности.

3. Инструмент должен оставаться в целости и сохранности во время его использования, если только его уничтожение не продиктовано соображениями безопасности или если это не входит в его функцию.

Немного отклонюсь от выбранной темы. Интеллект собаки гораздо выше, чем у любого создаваемого робоавтомобиля. При этом, современное общество не приходит в ужас от мысли о том, что собака может принять неверное решение, которое приведёт к смерти человека. Зато робоавтомобили заставляют мировое сознание трепетать от страха за свои жизни.

Мне кажется, немного фатализма в данной дискуссии лишним не будет. Считается, что смертность на дорогах снизится. И это прекрасно. А если это будет моя смерть? Все мы смертны, не ДТП, так поскользнусь и ударюсь головой, а нет, так и от старости умереть можно.

Грубое сравнение, конечно, где не только собаки виноваты, но конечный результат ожидаем.

А ДТП с гугломобилем вроде уже было, но спасло его то, что не на дорогах общественного пользования, вроде?

Действительно, с собакой пример не самый удачный я привёл. Суть в том, что есть некая сущность, принимающая решения за тебя. При этом, эта сущность принадлежит тебе. Должна ли она стараться сохранить тебе жизнь, если при этом могут пострадать другие? Безусловно, должна. А вот если эта сущность принадлежит государству, то должна играть в интересах государства, т.е. минимизировать жертвы среди безликого населения.

Я за то, чтобы автомобиль играл в интересах собственника в сложных ситуациях.

Один хрен никто и никогда не читает

— Как так получилось, что вы задавили 57 человек?

— Еду я под горку, груженый щебнем, вдруг тормоза отказывают. Скорость растет, надо что–то предпринимать... И у меня выбор — либо давить маленького мальчика, либо врезаться в рынок.

— И что же вы выбрали?

— Мальчика, конечно.

— А как тогда 57 человек погибли?

— Ну а кто знал, что он на рынок побежит?

— Еду я под горку, груженый щебнем, вдруг тормоза отказывают. Скорость растет, надо что–то предпринимать... И у меня выбор : Либо включить автопилот, пусть сам разбирается....